資料來源:行政院

進入2026年,人工智慧已不再只是技術創新與產業應用的話題,而是各國政府、跨國企業、國際組織必須正面面對的治理挑戰。AI 的滲透範圍從工廠自動化、軍事指揮、金融決策,一路延伸到選舉、輿論操控與文化產業,使其成為高度政治化、戰略化的議題。2026年的 AI 政策治理,將圍繞三個關鍵維度展開:國際規範與競合、國內治理制度化、以及技術倫理與社會接受度。

國際規範的碎片化與競爭化

2026年的 AI 政策治理,很可能出現「規範碎片化」的趨勢:歐美國家仍將嘗試推動跨國準則,例如歐盟的《AI Act》與美國的責任型 AI 準則,會在雙邊與多邊談判中被當作標準輸出工具。然而,中國、俄羅斯與部分新興市場,則可能形成替代性的規範體系,強調國家安全與數據主權,拒絕完全接受西方標準。結果是全球 AI 治理不會像氣候變遷般逐步形成「大框架」,而更可能出現多個區域性、陣營化的規則體系。

歐盟人工智慧政策(資料來源:KPMG)

對跨國企業而言,這意味著合規成本急劇上升。若一家公司同時在歐盟、東南亞與中國營運,勢必需要維護三套以上的合規機制。2026年的治理挑戰,不是單一國家的政策,而是如何在「多重規範衝突」中生存。這也將迫使企業加強「政策地圖」能力,能快速判讀不同司法管轄區的規則差異,並透過政治遊說、產業協會或跨國談判平台來尋求緩衝。

國家安全驅動下的政策強化

AI 治理在2026年將更深刻地被「國安化」。在烏克蘭戰爭與台海緊張局勢的背景下,各國政府逐漸把 AI 當作戰略性資產來管理。AI 的演算法模型、晶片硬體、數據資源被視為國家安全關鍵要素,美國與盟國會延續出口管制與投資審查,中國則進一步強化技術自立與產業鏈安全。

政策治理因此不僅限於「如何避免偏見與濫用」,而是延伸至「如何確保敵國無法取得敏感模型」以及「如何避免 AI 成為外部操弄民主的武器」。例如,生成式 AI 已經被證明能製造大規模虛假資訊,2026年的大選將檢驗各國是否有能力建構防禦體系。這也代表,AI 政策將逐漸與網路安全、選舉制度、防衛工業政策綁定,成為「國家安全三位一體」的一環。

國內治理制度化與監管機構的崛起

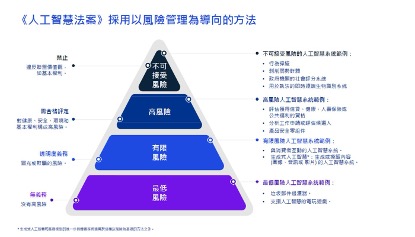

在國內層面,許多國家將建立更正式的 AI 監管架構,歐盟已率先透過立法建立「風險分類—事前審查—市場監督」的治理流程,美國雖未必走向統一立法,但會透過行政部門、州政府與產業自律組織建立「分散監管網」。亞洲國家則可能仿效金融監管模式,設置「AI 監理沙盒」來平衡創新與風險控制。

2026年,更多國家將成立獨立或半獨立的 AI 管理機構,負責審查高風險 AI 系統,例如自駕車決策演算法、軍事無人機控制系統、醫療診斷模型等。這類監管機構將成為新一輪政治角力場域:一方面政府希望強化透明度,另一方面企業則擔心創新被扼殺。如何在兩者之間取得平衡,將是國內 AI 治理的核心爭點。

倫理、透明與社會接受度的拉鋸

除了國安與監管,AI 治理必須處理倫理與社會接受度,2026年,隨著生成式 AI 滲透到新聞、教育與司法,公眾將更加關切「透明」與「問責」問題。AI 是否需要標示出「這是機器生成的內容」?AI 錯誤造成的醫療或金融損失,責任應由企業、政府還是個人承擔?這些爭議將推動「責任鏈條」立法,要求 AI 供應商在產品設計階段就必須設計可追溯的責任機制。

社會接受度也會成為政策治理的壓力來源。若 AI 導致大規模失業或加劇不平等,社會輿論可能迫使政府採取「AI 稅」或「再分配政策」,要求大型科技企業將部分利潤回饋於勞動力再培訓。2026年的 AI 治理,不能只看技術安全,更必須回應社會正義與公平分配的政治需求。

產業治理與企業策略

對企業來說,AI 政策治理的演進將直接影響商業模式。大型科技公司必須在跨國合規、演算法透明、數據治理等領域投入龐大資源。中小企業則可能因成本過高而選擇「依附模式」,依靠大型平台提供的合規框架來降低風險。這會造成產業集中度上升,進一步強化少數科技巨頭的影響力。

同時,企業在策略上需要預先佈局「多層治理韌性」。例如,將研發中心分散至不同司法轄區,以降低單一政策衝擊;或透過產業聯盟共同與政府談判,爭取更合理的規範。2026年的 AI 政策治理,將使企業從單純的技術競爭轉變為「政策適應力」的較量。

預判與展望

綜合來看,2026年的人工智慧政策治理將呈現「安全化—制度化—社會化」的三重動態。國際間的規範競合將持續,國內的監管機構會逐步成形,而社會輿論與倫理需求會將 AI 治理推向更高層次。這不僅是一場技術之爭,更是一場政治、經濟與文化的綜合博弈。

長遠而言,若無法建立某種跨國協調機制,AI 治理可能會陷入「多極競爭—合規成本高漲—創新分化」的困境。相反地,若主要國家能在最低限度上達成共識,例如共同打擊虛假資訊、建立跨境資料安全協議,AI 治理或許能形成「競爭中合作」的新平衡。